Wer in den Naturwissenschaften einmal mit einem Nobelpreis geadelt ist, gehört endgültig zur Elite seines Fachs, die auch jenseits der jeweiligen Disziplingrenzen gehört und wahrgenommen wird. Der Quantenphysiker Robert Laughlin wurde 1998 vom Nobel-Komitee ausgezeichnet und nutzt seine Popularität bisweilen auch, um seine Kollegen zur Räson zu rufen. Die hochgradig spekulativen Konzepte, wie etwa die Stringtheorie, sind ihm suspekt. In einem Interview mit der Neuen Zürcher Zeitung erklärt er, weshalb.

Laughlin wendet sich gegen einen naiven Reduktionismus und plädiert für eine Sichtweise, die emergente Phänomene fokussiert: Das Ganze ist mehr als die Summe seiner Teile

Robert Laughlin, der an der Stanford University forscht und lehrt, hat für seinen Beitrag zur Klärung des sog. "Quanten-Hall-Effekts"1 bereits 1998 den Nobelpreis für Physik erhalten. Er war damals gerade 48 Jahre alt und damit geradezu unverschämt jung.

Seitdem schreibt Laughlin bisweilen auch populärwissenschaftlichere Bücher. In seinem aktuellen Buch "Abschied von der Weltformel" erinnert er seine Zunft an die Grundlagen seiner Disziplin.

"Wir Physiker sollten sorgfältig darüber nachdenken, was unsere Disziplin eigentlich ausmacht. Eigenwerbung mit für das Publikum eingängigen, tollen Ideen zerstört auf längere Sicht das Image der Physik, die ich liebe. Meiner Meinung nach sind Gesetze das Einzige, was wir haben und was andere Wissenschaften und Studenten von uns wollen. Diese Erwartung einzulösen, erfordert eine strengere experimentelle Disziplin."

Ihm sind spekulative Theorien höchst suspekt, da sie sich der Falsifizierbarkeit entziehen. Dazu zählt er u.a. die seit den frühen 90ern modische Stringtheorie. Laughlin betont:

"Man muss trennen zwischen Wahrheit und Ideologie. Die Physik ist eine experimentelle Wissenschaft. Ihre moralische Autorität gründet auf der Falsifikation, also der Überprüfbarkeit ihrer Aussagen, und nicht allein auf grossartigen Ideen."

Daneben kritisiert er alle Sichtweisen, die zwischen "fundamentalen" und "nicht-fundamentalen" Naturgesetzen unterscheiden. Experimentell sei dies nicht haltbar und jeder Physiker wisse im Grunde, daß sich viele Gesetz- oder besser: Regelmäßigkeiten nicht aus den Eigenschaften der einzelnen Atome erklären ließen.

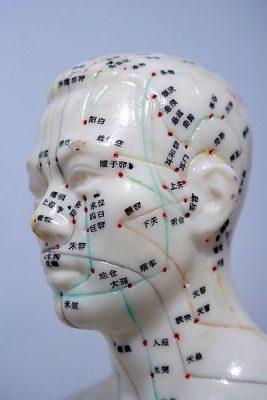

Laughlin bezeichnet dies als Emergenz,2 also die Tatsache, daß sich bestimmte Phänomene erst auf einer Makroebene als Effekte des Zusammenspiels der systembildenden Einzelteile zeigen. Er kritisiert damit alle "reduktionistischen" Ansätze, die die Natur durch Zerlegung in immer kleinere Elemente zu erklären suchen.

Auf die Frage, ob sich denn letztlich nicht doch alles auf einige wenige basale Naturgesetze zurückführen ließe, kontert er:

"Ich will die Suche nach einer «Theorie von allem» ja auch keinem Physiker verbieten. Allerdings glaube ich aus grundsätzlichen Überlegungen nicht an den Erfolg dieser Bemühungen. Das zeigt zum Beispiel die Geschichte der Entdeckung der Supraleitung. Wir müssen uns von einer dogmatisch vertretenen, reduktionistischen Sicht der Welt verabschieden. Sie kann das Finden von Gesetzen auch behindern."

Und Laughlin kündigt abschließend ein neues Buch an, dessen Titel bereits vielversprechend klingt, dessen Inhaltsangabe aber noch mehr aufhorchen läßt:

"Es heisst «Das Verbrechen der Vernunft» und thematisiert die für eine freie Gesellschaft bedrohliche Entwicklung, dass wissenschaftliche Erkenntnisse aus wirtschaftlichen, politischen oder militärischen Gründen zunehmend geheim gehalten werden."

Links:

- Interview mit Robert Laughlin: Die Grenzen unseres Wissens sind mitnichten erreicht, NZZ, 13.1.2008

- Website von Robert Laughlin am Physik-Department der Standford University

Literaturempfehlung:

- Robert B. Laughlin (2007): Abschied von der Weltformel. Die Neuerfindung der Physik. Piper-Verlag.

- Robert B. Laughlin (2008): Verbrechen der Vernunft. Betrug an der Wissensgesellschaft, Suhrkamp

- Soweit ich verstehe, geht es beim Quanten-Hall-Effekt darum, daß Halbleiter bei sehr tiefen Temperaturen und hohen Magnetfeldern bestimmte (nicht unbedingt erwartete) Eigenschaften zeigen. Der Widerstand korreliert nicht linear mit dem angelegten Magnetfeld, sondern ist diskontinuierlich. [↩]

- Beispiele für Emergenz wären also etwa Wärme, Magnetismus oder die elastischen Eigenschaften eines Körpers. [↩]

7 Gedanken zu „Wider die modische Spekulation » Robert Laughlin erinnert die Physik an ihre Grundlagen | kurz&knapp 17“

Ich finde Laughlin erweist der Wissenschaft einen Bärendienst und habe das Gefühl, dass Herr Laughlin die experimentelle Physik als Königsdisziplin installieren möchte – auf Kosten der theoretischen.

So recht kaufe ich Laughlin das Argument nicht ab, dass er niemandem die Suche nach der Weltformel verbieten möchte. Nicht wenn er im gleichen Atemzug dieser Suche jede Erfolgsaussicht abspricht, weil ER persönlich das so sieht. Also sorry, wer ist jetzt hier dogmatisch und reduktionistisch?

Es gibt nun mal zwei Konzepte an die Wissenschaft heranzugehen. Man macht Experimente und versucht sie mit einer Theorie und Gesetzen zu erklären oder man nimmt die bestehenden Gesetze entwickelt sie weiter und versucht die daraus resultierenden Vorhersagen mit Experimenten zu testen. Die induktive und deduktive Sichtweise.

Beide Konzepte haben sich historisch gesehen bewährt. Einstein war der bisher bekannteste Vertreter der deduktiven Wissenschaft und der erste, der an sowas wie einer Weltformel gearbeitet hat. 1905 waren seine Vorhersagen zunächst auch nicht falsifizierbar, weil die Vorhersagen die damaligen technischen Möglichkeiten überstiegen. Heute über 100 Jahre später sind die Relativitätstheorien vielfach überprüft und bestätigt worden.

Dass die String-Theorie nicht falsifizierbar ist, dass kann ich auch nicht so stehen lassen. Es ist nicht ganz so einfach, weil wir entsprechend hohe Energie brauchen, aber grundsätzlich macht auch die Stringtheorie vorhersagen, die sich eventuell mit dem neuen Teilchenbeschleuniger am CERN testen lassen.

http://cerncourier.com/cws/article/cern/28895

Das Nobelpreisträger auch mal Müll erzählen können, hat James Watson mit seinen rassistischen Äußerungen bewiesen:

http://fisch-blog.blog.de/2007/10/21/rassismus_als_pr_trick_gene_intelligenz_~3170280

Es stimmt auch, dass Wissenschaftler ab und an über’s Ziel hinausschießen und ausgemachten Blödsinn erzählen und abstruse Thesen in die Welt setzen. Aber das liegt weniger daran, dass ihr Zweig der Wissenschaft falsch ist, sondern dass die beteligten Wissenschaftler auch Menschen und daher fehlbar sind.

Ich verstehe auch nicht so recht, inwiefern die Suche nach der Weltformel die Suche nach neuen Gesetzmäßigkeiten behindern soll. Bisher hat kein Theoretiker gefordert, alle praktischen und anwendungsbezogene Forschung zugunsten seiner eigenen einzustellen und ich kann auch nicht sehen, dass die Theortiker glauben, ihre Sichtweise und ihre Forschung sei mehr wert, als die der Experimentalphysiker. Von ein paar Ausnahmen abgesehen – aber auch das ist eher eine menschliche Fehlleistung und keine wissenschaftliche.

Und in der Politik, Wirtschaft und Öffentlichkeit hat die anwendungsbezogene Forschung eher sogar einen höheren Stellenwert als die theoretische. Warum sonst kommt immer die gleiche Frage: Wozu soll das gut sein?

Das mit der Geheimhaltung der Forschung klingt reißerisch, habe ich so noch nie erlebt. Ich frage daher mal? Wer weiß von Fällen in denen Forschung in der heutigen Zeit geheimgehalten wurde?

@Planetenbloggerin:

Du hast natürlich zu 100% Recht, wenn Du darauf verweist, daß deduktive und induktive Vorgehensweisen seit jeher praktiziert werden und auch ihre Legitimität haben. Kein Thema, da stimme ich voll mit Dir überein.

Und ganz genauso berechtigt ist Dein Hinweis, daß auch der Nobelpreistitel niemanden davor bewahrt, Unsinn zu reden. Man sollte hier ebenso kritisch sein, wie bei allen anderen Autoren und Wissenschaftlern auch. Allerdings sehe ich hier schon einen Unterschied, wenn der „gspinnerte“ Watson auf seine alten Tage glaubt, seine soziobiologischen Vorurteile rausposaunen zu müssen oder wenn Laughlin eben seinen Standpunkt formuliert. Über Laughlins Thesen kann man streiten, Watsons Äußerungen sind nicht mal das wert.

Deine Argumentation, daß auch alle spekulativen Theorien sich zukünftig bewähren können und müssen, ist übrigens nach meiner Meinung recht gewichtig. Sehe ich genauso! Wenn man verkürzt immer nur die jeweilige Gegenwart in den Blick nimmt, könnte man Laughlin zustimmen (denn heute sind String-Theorien eben – so wie ich es verstehe – nicht oder nur unzureichend falsifizierbar). Aber – wie der Blick in die Wissenschaftsgeschichte lehrt – es waren so oft erst spätere Forschergenerationen, die die Beweise lieferten.

Etwas skeptischer bin ich im Bezug auf die „Ressourcenfrage“: denn insgesamt ist es (man nehme nur die von Dir erwähnten Teilchenbeschleuniger) doch so, daß solche Großforschungsprojekte Zeit und Geld „fressen“. Es sind (forschungs-)politische Entscheidungen und diese binden dann Ressourcen, die eben nicht beliebig für andere Ziele zur Verfügung stehen. Da gibt es definitiv Konflikte. Man müßte das aber jeweils im Einzelfall ansehen.

Und bzgl. deines letzten Hinweises, daß Dir die These von der „Geheimhaltung der Forschung“ zu reißerisch klingt, muß ich mich auf die Seite von Laughlin schlagen: man nehme eben nur mal die Forschungen, die unter der Regie von Militärs ablaufen, deren Befunde bekommt man stets nur am Rande, viel später oder gar nicht mit.

Oder nimm – da gibt und gäbe es unendlich viele Beispiele – nur die Medizin und Pharmazie. Da ist Transparenz und wissenschaftlicher Diskurs oft ein Fremdwort. Hier spielen ökonomische Interessen und Patentschutzgedanken eine viel größere Rolle.

Das mit den Ressourcen ist natürlich zu diskutieren. Diese Grundsatzdiskussion stellt sich ja auch immer bei der Raumfahrt und es brennt mir auf den Fingern. Denn das Problem bei dieser Art der Diskussion ist, dass sie in vielen Fällen mit unehrlichen, um nichtzusagen falschen Argumenten und Zahlen geführt wird.

Da wird dann der Etat von CERN, was ein weltweit einzigartiges und unter internationaler Beteiligung gebautes und genutztes Wissenschaftszentrum ist, wo außerdem sehr viele Experimente durchgeführt werden – u.a. auch für angewandte und geophysikalische Forschung – mit dem Etat der deutschen (!) Physiker verglichen.

Wie falsch ist das denn? Oder es werden irgendwelche Zahlen in den Raum geworfen.

1 Milliarde klingt erstmal viel. Wenn man das aber mit den vorraussichtlichen Baukosten für eine neue U-Bahn-Anbindung in Köln vergleicht, die sich auf 1,1 Milliarden belaufen…Dann hört sich das auf einmal ganz anders an.

Oder wenn man bedenkt, dass ein 5stelliger Betrag für den Erhalt einer simplen Holzbrücke vor dem oastasiatischen Institut in Köln jedes Jahr fällig ist.

Diskussion ja, aber dann bitte eine ehrliche, die sich nicht nur mit der kurzfristigen Anwendung innerhalb der nächsten 5 Jahre beschäftigt.

Wollen wir wirklich eine Wissenschaft, die nur dann eine Existenzberechtigung hat, wenn sie beispielsweise eine effizientere Methode findet, Bier zu kühlen? Oder wollen wir eine Wissenschaft, die im wahrsten Sinne des Wortes Wissen schafft, von der noch Generationen von Menschen weltweit profitieren werden.

Und was ist uns das wert? Den Gegenwert einer neuen U-Bahn-Trasse in Köln?

Zufällig habe ich mich in der letzten Zeit auch mit Laughlin beschäftigt. Bei allem Verständnis, das ich gerne gewillt bin für seine Gedanken aufzubringen: Was genau ist „Emergenz“? Darüber lässt sich viel und nett plaudern — die Beispiele von Laughlin sind beeindruckend dazu, wenn man in neueren Artikeln von ihm herumstöbert. Doch eine letztliche Klärung des Begriffs gelingt nicht.

Bei meinen Streifzügen stieß ich über den Wikipedia-Eintrag http://en.wikipedia.org/wiki/Emergence auf einen sehr interessanten Artikel von Alex Ryan, der sich an einer mathematisch-formalen Begriffsfassung bemüht: „Emergence is coupled to scope, not level“. Ich bin mir noch nicht abschließend im Klaren darüber, ob die Formalisierung nicht zu deskriptiv ist und so im Grunde auch nur bedingt das Phänomen der „Emergenz“ zu verstehen hilft.

Eines ist jedoch sicher: Die Welt würde ohne den Motor des Atomaren, genauer, den vier Fundamentalkräften, nicht laufen und nicht existieren. Aber aus dem Atomaren lassen sich Phänomene wie Bewusstsein, Intelligenz etc. nicht ableiten. Die Summe der Möglichkeiten, mit denen Strukturen gebildet werden können, laufen ins schier Unendliche. So gilt es viel zu lernen über das, was Systemen auf anderen Ebenen neue und andersartige Eigenschaften verleiht, die im Grunde gar losgelöst vom atomaren Antriebsmotor verstanden und betrachtet werden können. Ich glaube, man kann dabei viel mit und aus der Informatik lernen, da sie — etwas philosophisch interpretiert — eine Strukturwissenschaft von Raum und Zeit ist ;-) Vielleicht gelingt uns dann eines Tages ein präzises Verständnis von dem, was Laughlin als „Emergenz“ bezeichnet.

Herzliche Grüße,

Dominikus

@Planetenbloggerin:

Deinem abschließenden Satz ist kaum noch was hinzuzufügen:

Wobei ich eben noch stärker betonen würde, daß Wissenschaft mißverstanden und kastriert wird, wenn man ihr zumutet, stets die Anwendungsbezüge offenzulegen. Natürlich soll und kann es das auch geben, daß man vor einer Untersuchung die möglichen Anwendungen benennen kann. Aber oft genug ergibt es sich eben erst Jahre (oder gar Generationen) später, daß man das Wissen und die Möglichkeiten hat, um auf der Basis der lange zurückliegenden „Entdeckung“ etwas Segensreiches herzustellen.

Das war jetzt auch wieder sehr blumig formuliert, aber ich hoffe, es ist verständlich geworden. Ansonsten mag ich noch auf die Pläne für den Münchner Transrapid oder andere Verkehrsprojekte hinweisen, die ebenfalls viele Milliarden verschlingen. Da ist die Kölner-U-Bahn nur ein Beispiel unter die vielen, das die Verhältnisse wieder zurechtrückt. Allerdings sind (obwohl wir hier lamentieren, daß für andere Projekte viel Geld zur Verfügung steht) die Ressourcen dennoch begrenzt…

Und wenn ich daran denke, daß verdienstvolle Lehrstühle in den Sozial- und Geisteswissenschaften (es geht hier meist um Einspareffekte von einigen 10.000,- Euro!) ohne Not kaputtgespart werden, muß ich doch wieder daran zweifeln, ob hier gesamtgesellschaftlich die richtigen Prioritäten gesetzt sind…

@Dominikus:

Ich teile Deine Feststellung, daß „Emergenz“ doch ein recht schwammiger Begriff bleibt. Vielleicht auch nicht weiter erstaunlich, denn die Konzepte, die mit der Emergenzbegrifflichkeit verknüpft sind, variieren von Autor zu Autor und von Disziplin zu Disziplin.

Robert Laughlins Ansatz war mir bislang ehrlicherweise nicht bekannt. Ich hatte im Text dennoch versucht seine These zusammenzufassen; denn so wie ich ihn verstehe, begreift er unter Emergenz

Und in der Fußnote habe ich als Beispiele Wärme, Magnetismus oder elastische Körpereigenschaften angeführt. Eine zufriedenstellende Definition haben wir damit freilich noch nicht.

Wenn ich mich selbst an einer Begriffsklärung versuchen sollte, dann würde ich damit beginnen, daß Emergenz solche Phänomene bezeichnet, die ein Gesamtsystem aufweist, ohne daß diese Eigenschaften auf die Systembestandteile zurückgeführt werden könnten. Das heißt also, daß emergente Eigenschaften irreduzibel sind.

Und hier kommen wir an den Punkt, weshalb wir (Du erwähnst die Beispiele) wohl Bewußtsein oder Intelligenz als „emergente“ Eigenschaften bezeichnen könnten. In einer schwächeren Lesart könnte man sagen, daß uns die Zusammenhänge zwischen neuronaler Aktivität und bspw. dem „Phänomen“ Bewußtsein (bislang) nicht bekannt sind und insofern die beobachtbare „Tatsache Bewußtsein“ erst auf einer höheren Systemebene „auftaucht“ oder sichtbar wird.

Eine stärkere Lesart könnte sogar behaupten, daß sich die Emergenz genau dadurch auszeichnet, daß eben die emergente Eigenschaft nicht durch die (isolierten) Eigenschaften der Systembestandteile restlos determiniert ist, sondern daß sich im Zusammenspiel und infolge von Selbstorganisationsprozessen etwas originär Neues zeigt.

Auch kein tolle Definition, aber eben meine „Annäherung“…

P.S.: Hätte man mir vor Jahren die Informatik als „Strukturwissenschaft von Raum und Zeit“ schmackhaft gemacht, hätte ich vielleicht ein anderes Studienfach gewählt. ;-)